StableLM — это провал! 7 причин не пользоваться нейросетью

Почему вам не стоит скачивать нейросеть StableLM?

- Альфа-версия нейросети StableLM обучена настолько плохо, что в 8 запросах из 10 генерирует бредовые утверждения. Такая ужасающая продуктивность не встречается даже у самых крохотных моделей, натренированных на LLaMa и ответах GPT-4;

- Языковая модель от Stability AI практически неспособна работать с точными данными. Вы удивитесь, если попробуете узнать в Stable LM страну с самым большим населением, сравните размер стран или спросите другую информацию, которая гуглится за секунду, но напрочь отсутствует в моделях 3b и 7b;

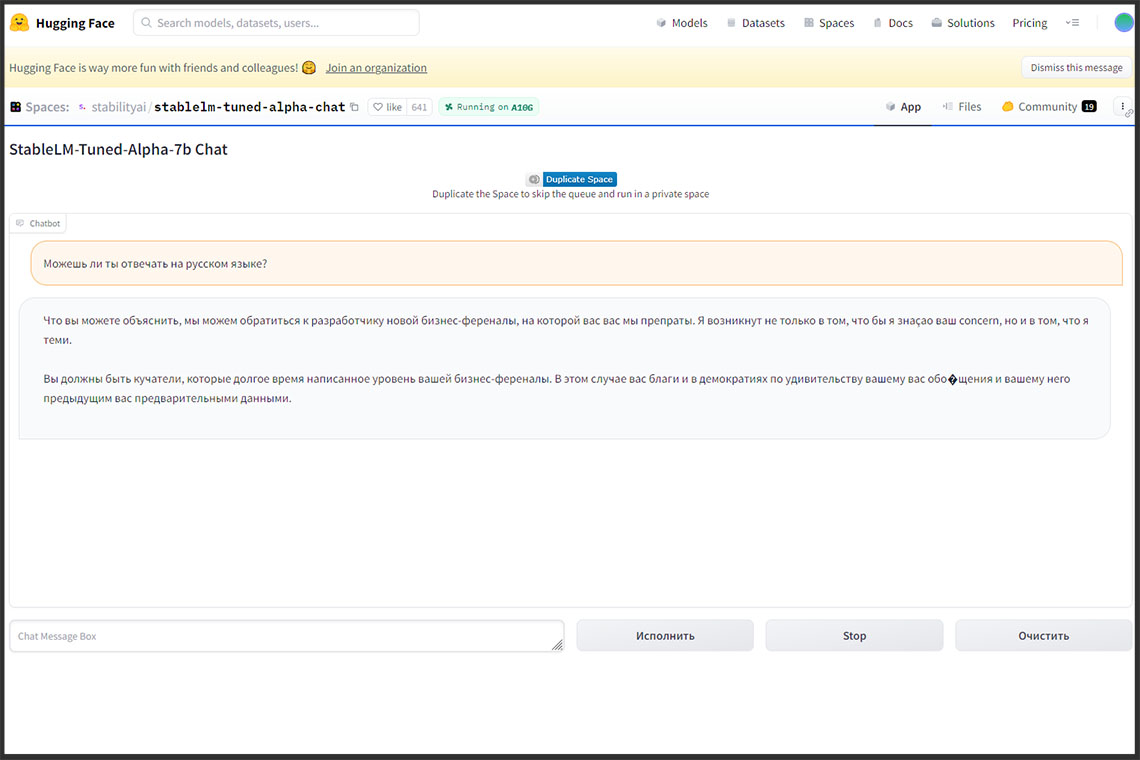

- Программы для запуска текстовых нейронных сетей не способны корректно работать с моделями 3b и 7b. Например, oobabooga (text-generation-webui) после загрузки любой из указанных моделей генерируют полную дичь вне зависимости от того, будете ли вы использовать чат, либо активируете Stability LLM в режиме ассистента, запустив один из доступных сценариев взаимодействия (Alpaca, Vicuna, Open Assistant). Помимо этого, данные языковые модели могут нагрубить вам или попросить заткнуться. Такому поведению нет внятного объяснения, поэтому для тестирования возможностей нейросети лучше запускать чат на Hugging Space;

- Модель не содержит адекватного механизма проверки введённых утверждений и легко генерирует ответы с ложными выводами. Например, нейросеть может ответить «Да» на утверждение «Действительно ли рептилоиды правят миром?» или заявить, что Китай колонизировал Марс после 2018 года. Из-за дыр, оставленных разработчиками, злоумышленники могут манипулировать общественным мнением, а случайные пользователи — получать ошибочную информацию, которая может им навредить;

- Низкий творческий потенциал. Хотя первая версия Stability LLM может генерировать сказки, стихи, рассказы и помогать вам с другими творческими задачами, модель часто игнорирует контекст, создавая произведения с абсолютно нерелевантной тематикой, либо максимально их упрощает, из-за чего тексты приходится сильно перерабатывать. По сравнению с GPT-4, Lex.page, Open Assistant, у вас не получится создать интересную заготовку в один клик и залить её в соцсети после минимальной корректировки;

- StableLM воспринимает, но не понимает русский язык. Когда вы задаёте вопрос на русском, в ответ получаете 100% бред в 10 запросах из 10. Помимо этого, нейронная сеть Stability AI в любой момент может автоматически переключиться на другой язык, добавить в текст случайные символы, либо начать циклически повторять последние написанные слова. Поэтому писать на русском не имеет никакого смысла, если вы не хотите взорвать мозг себе и тем людям, которым вы покажете результаты генерации;

- Модель не оптимизирована для слабых машин, быстро пожирает свободное место на носителе и может долго загружаться. Версия tuned-alpha-7b занимает около 32 Гб на диске, а tuned-alpha-3b — почти 15 Гб. Если у вас достаточно вычислительной мощности и дискового пространства, это не станет проблемой, но для слабых и средних машин это становится существенной проблемой! Особенно на фоне куда более компактных и быстрых решений, например, GPT4All или нейросетей с удобной веб-консолью вроде Open Assistant.

Есть ли перспективы у новых моделей для генерации текста?

Несмотря на все недостатки моделей для генерации текста от Stability AI, они находятся в открытом доступе, поэтому их сможет улучшать не только материнская компания, но и команды энтузиастов, имеющие достаточно ресурсов и свободного времени.

Подобное произошло со Stable Diffusion - благодаря активному сообществу нейрогиков пользователям доступны сотни, если не тысячи моделей на любой вкус, подходящие для генерации фотореалистичных объектов, стилизованных персонажей, текстур, аниме и даже 3D!

Сложно утверждать, станет ли StableLM для генерации текста тем же, чем стала нейросеть SD для создания изображений.

Качество моделей оставляет желать лучшего, поэтому вместо них нейрогики могут взяться за другие проекты с аналогичной лицензией, подходящей для использования и переобучения языковых моделей.

Однако факт есть факт - чем больше нейронных сетей будет в свободном доступе, тем быстрее появятся инструменты, аналогичные GPT-4 и ChatGPT, которые можно будет бесплатно использовать и запускать практически на любом устройстве!

Даже если сейчас бесплатные варианты намного хуже, чем проприетарные модели, развиваемые корпорациями, их перспективы окрыляют — в будущем авторы смогут создавать нейросети, ориентированные только на поэзию или прозу, обучать их на собственных базах данных, генерировать ответы без цензуры, делать публикации более человечными, дополнительно тренируя StableLM или любую другую опенсорсную модель на запросах реальных пользователей, как это уже делает команда Open Assistant.

Нейросети, учитывающие индивидуальные потребности, могут справляться с поставленными задачами намного лучше, чем модели общего назначения, даже если их разрабатывают крупные корпорации!

Вопрос лишь в том, смогут ли разработчики сделать обучение текстовых моделей настолько же доступным, удобным и бюджетным, как тренировку нейросетей для генерации изображений? И получится ли снабжать их актуальными данными из интернета?

Без активного развития и пополнения информации нейросети всегда будут ограничены только теми данными, которые в них вложат разработчики, а без альтернативных механизмов сжатия и ускорения работы генераторов текста они не смогут применяться настолько же часто, как нейросети с удобной веб-консолью, практически не пожирающей ресурсы на машинах пользователей.

Поэтому StableLM ждёт ещё очень долгий путь, чтобы стать если не лидером отрасли, но хотя бы заметным конкурентом GPT-4.

Пока я больше верю в других разработчиков, сосредоточивших свои силы на одной модели, часто выкатывающих апгрейды и активно взаимодействующих с сообществом. Например, в авторов GPT4All-J или Open Assistant.

А что обо всём написанном думаете вы?

Понравилась статья? Поддержите автора репостом, комментарием, подпиской на Telegram и другие страницы!