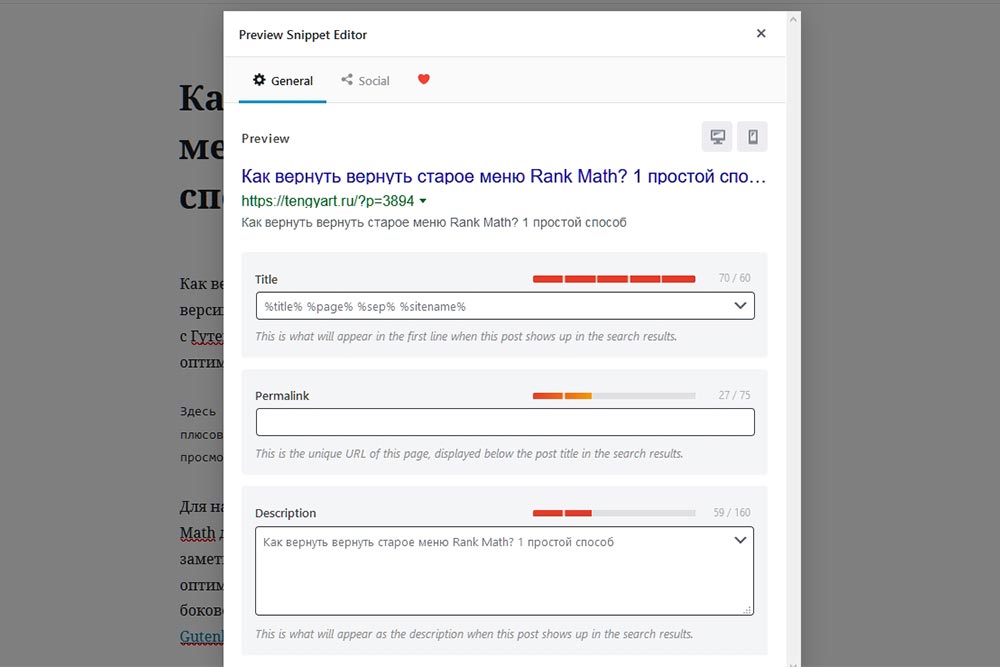

Как установить Stable Diffusion и Waifu Diffusion на ПК?

Самый простой способ установить нейросеть Stable Diffusion на ПК с операционной системой Windows 10 — скачать дистрибутив NMKD с сайта itch.io, запустить установщик и загрузить все компоненты, предлагаемые в графическом интерфейсе программы.

Главные преимущества GUI — экономия времени и удобство ввода.

Вам не нужно будет разбираться с git, Conda и Python, искать отдельный софт для увеличения получаемых картинок и учить консольные команды! Всё необходимое для работы устанавливается с помощью встроенного инсталлятора, запускающегося при первом входе в интерфейс нейросети:

Хотя дистрибутив NMKD не работает "из коробки", он максимально упрощает взаимодействие со Stable Diffusion. Именно поэтому я рекомендую использовать его авторам, никогда раньше не увлекавшимся программированием, не знающим, что такое "нейронные сети" и как ими пользоваться.

Особенности NMKD Stable Diffusion GUI:

- ПО работает исключительно с видеокартами Nvidia. На момента написания статьи видеокарты от AMD не поддерживаются;

- Во время инсталляции скачивает SD версии 1.4;

- Чтобы использовать Waifu Diffusion, Trinart и другие модели нейросети, вам понадобится скачать их самостоятельно (обновление и поиск сторонних моделей не входит в интерфейс NMKD);

- В версии Stable Diffusion для ПК отсутствует цензура и фильтрация. Поэтому за создаваемый контент и степень его приемлемости несёте ответственность только вы, а не создатель софта;

- Программа находится в разработке, так что иногда могут возникать баги. Рекомендую периодически заходить на страницу автора и скачивать новую версию GUI;

- Поддерживает преобразование из текста в изображение, генерацию картинок на основе другого изображения или одного из предварительно настроенных «концептов», идущих в комплекте с NMKD;

- Демонстрирует превью и информацию о сгенерированных изображениях;

- В настройках дистрибутива можно активировать масштабирование картинок (RealESRGAN), позволяющее увеличить арты в 2-4 раза, а также опцию «восстановление лица» (GFPGAN), помогающую улучшить результат при вводе сложных текстовых запросов;

- Запуск нескольких текстовых подсказок одновременно;

- Поддерживает создание бесшовных текстур. Эта опция будет особенно полезна для авторов, создающих концепт-арты и инди-игры;

- Использует весь потенциал GPU — скорость создания изображений зависит исключительно от вашей видеокарты.

Системные требования:

- Windows 10/11 64-bit;

- Последний графический процессор Nvidia, предпочтительно RTX;

- 16 ГБ ОЗУ;

- 4 ГБ VRAM (для медленного режима с малым количеством памяти) или 6+ ГБ VRAM (для быстрого режима с большим количеством функций);

- Как минимум 11 ГБ дискового пространства для установки. Желательно использовать SSD для лучшей производительности и выделить не менее 20-40 ГБ на диске, если вы планируете добавлять альтернативные модели нейросети.

Как установить Stable Diffusion?

- Перейдите на страницу дистрибутива и нажмите «Скачать сейчас» («Download Now»);

- Перед вами появится страница, на которой предлагают заплатить 4$ или другую сумму. Ничего платить не надо, достаточно нажать вверху на надпись «Нет, спасибо, лучше отправьте меня к загрузкам» («No thanks, just take me to the downloads»);

- Снова нажмите на кнопку «Скачать» («Download»);

- Дождитесь, пока сохранится архив SD-GUI.7z;

- Распакуйте содержимое архива. Желательно разместить папку с файлами прямо в корне диска C;

- Запустите программу, нажмите «Установить» («Install») при первом запуске SD.

После установки компонентов вы сразу можете ввести текстовое описание для будущих картинок, добавить подсказки или поменять настройки в графическом интерфейсе нейросети.

Если во время установки что-то пошло не так, вы всегда можете переустановить «неудачные» элементы в меню программы:

Как установить Waifu Diffusion?

Чтобы установить Waifu Diffusion, скачайте модель нейросети на HuggingFace или нажмите на эту ссылку.

После скачивания модели откройте папку «C:\SD-GUI-1.4.0\Data\models» и скопируйте в неё WD.

UPD: вышла новая версия WD - 1.3. Скачать её и посмотреть важные особенности обновления можно по этой ссылке.

Если вам больше не нужна предыдущая модель нейросети, файл SD можно удалить, либо заменить название на «stable-diffusion-1.4.ckpt.beta». После этого модель не будет отображаться в списке доступных для использования.

Крайне редко может возникнуть баг, из-за которого не получается выбрать модель нейросети в настройках NMKD. В таком случае рекомендую переименовать файл WD в stable-diffusion-1.4.ckpt.

Переименовывать модели не принципиально. Я лишь однажды столкнулся со сбоем, когда программа не смогла "распознать" модель нейронной сети и предложила скачать SD заново.

До сбоя я тестировал WD сотни раз.

Если вы скачиваете 5-10 моделей, это лишь создаст ненужную путаницу, поэтому изменяйте имена файлов лишь в случае частых вылетов и других неприятных багов.

Когда вы работаете с двумя моделями, создание "альтернативного расширения" позволяет оставить только одну активную модель, не залезая в настройки GUI. Если их больше, куда проще залезть в графический интерфейс и выбрать в разделе "Settings" ("Stable Diffusion Model File") нужный файл, чем мучиться с постоянным переименовыванием или запоминать, что в какой "бета-версии" находится.

Установка альтернативных моделей (например, Trinart 1, 2, 3 или Hiten) происходит аналогичным образом — сначала вы скачиваете файл, затем добавляете в папку «Models», потом выбираете нужную модель в настройках GUI.

Если что-то не работает «из коробки» — закрываете и снова запускаете SD, либо переписываете название файла (заменяете тире на нижние подчёркивания, убираете кириллицу и пробелы, и так далее).

Неправильные символы - одна из самых частых ошибок, мешающих загрузке моделей нейронных сетей в NMKD Stable Diffusion GUI.

Если вы сталкиваетесь с частыми вылетами — попробуйте полностью удалить папку со всеми файлами нейронной сети и переустановить дистрибутив.

Сбоит Waifu Diffusion?

Уменьшите нагрузку на ПК — закройте браузер и другие ресурсоёмкие приложения, переключитесь на режим низкого потребления видеопамяти («Low Memory Mode») в настройках («Settings»).

Зависает система?

Установите MSI Afterburner или другое ПО, чтобы проверить, насколько разогреваются видеокарта и процессор во время работы нейросети.

Перегрев - одна из основных причин "отваливающейся" видеокарты.

Чтобы избежать перегрева, замените или модифицируйте охлаждение. Например, установите мощные кулеры либо «водянку», уберите пыль внутри и снаружи системника, замените термопасту у процессора.

Возникают зелёные пиксели и полосы на всех сгенерированных артах?

Активируйте в настройках NMKD опцию «Use Full Precesion» («Использовать полную точность»). Помимо этого, функция может помочь с багами видеокарт 16-ой серии Nvidia GTX.

Главный недостаток последней настройки - её использование требует много VRAM, поэтому она может замедлить рендеринг и не подходит для карт с небольшим количеством видеопамяти.

Оптимальные настройки Stable Diffusion

Чем больше цифра параметра «Details» («Steps»), тем больше мелких деталей сгенерирует нейросеть. Учитывайте, что «улучшение детализации» негативно влияет на скорость создания артов!

Не обязательно выбирать максимальное значение, достаточно указать в SD и WD от 50 до 85 «шагов».

Параметр «Creativeness» («Guidance Scale») напрямую влияет на «креативность» изображения. Чем меньше цифра, тем больше нейросеть импровизирует, чем больше, тем точнее пытается реализовать ваш запрос.

Оптимальная "креативность" по "шкале рекомендаций" - от 8,5 до 12. Если вы уверены в своём запросе, можно ставить значения побольше. Если хотите, чтобы нейронная сеть интерпретировала текстовое описание шире и не ограничивалась запросом, используйте меньшие значения.

Поле в параметре «Seed» можно оставить пустым, либо задать в нём фиксированную цифру. Поле «Seed» позволяет поменять стартовую точку отрисовки арта, изменить стиль и уточнить начальный запрос.

Чаще всего я оставляю поле пустым, либо ставлю 2. В предыдущих версиях программы вместо «пустоты» лучше было вписывать -1.

Resolution - разрешение изображения. Здесь вы можете поменять размер картинки и соотношение сторон. Не забывайте, что нейросети выдают лучшие результаты с настройками по умолчанию - с разрешением 512х512 пикселей.

В выпадающем меню параметра Sampler можно выбрать алгоритм сэмплирования изображения. Если упрощать, в зависимости от выбранного сэмплера изменятся финальные «нейронные арты» — станут ближе к портретам или полноростовым концептам, заполнят фон деталями или уйдут в минимализм.

Лично я предпочитаю использовать k_euler, k_euler_a, ddim и k_dpm_2.

Дополнительные настройки NMKD Stable Diffusion GUI

Помимо базовых настроек, NMKD Stable Diffusion GUI поддерживает две расширенные опции — возможность перенимать стили изображения или концепта.

В первом случае изображение генерируется с учётом добавленного арта (снимка, картинки), где степень влияния (схожести) оригинала на текстовый запрос варьируется от 0,050 до 0,950 (от наименьшего к большему).

Во втором случае итоговый результат зависит от заранее обученного образца, «концепта». Образцы делятся на «объекты» и «стили». «Объекты» позволяют точнее генерировать определённые образы, включая существующих персонажей и людей, «стили» имитируют художников, либо фиксированные направления (чёрно-белые картины, картины маслом, иллюстрации).

Главное преимущество дополнительных настроек — возможность максимально приблизить текстовый запрос к вашей идее.

Лучше всего использовать опции по отдельности, чтобы не вносить дополнительные искажения, но их можно использовать и одновременно.

Здесь вы можете посмотреть примеры самых распространённых концептов. В предустановленной версии SD используется лишь часть из них.

Учитывайте, что представленная база не предназначена для скачивания готовых стилей, это лишь каталог с входными данными библиотеки текстовых инверсий HuggingFace.

Как увеличить размер артов в Stable Diffusion?

Размер артов в Stable Diffusion можно изменить 3-я способами:

- Увеличить разрешение исходного изображения. Этот способ замедлит создание артов и повысит нагрузку на вашу видеокарту;

- Использовать постобработку («волшебную палочку» в верхней части меню GUI). Среди опций постобработки есть увеличение разрешения («Upscaling») в 2-4 раза и «Восстановление лица» (об этом я расскажу чуть позже). Хотя апскейл тоже разогреет вашу видеокарту, скорость создания артов почти не просядет;

- Поднять разрешение с помощью стороннего софта. Например, Topaz Gigapixel. В таком случае вы можете увеличить размер артов вплоть до 6 раз, но это потребует дополнительных финансовых вложений (увы, ПО не бесплатное).

Как восстановить лица и улучшить арты?

Если по текстовому описанию получаются красивые изображения, но лица часто смещаются куда-то «не туда», вы можете использовать функцию «Восстановление лица» («Face Restoration») в настройках постобработки SD.

Начиная с версии NMKD 1.5, для восстановления лиц используются две модели — GFPGAN и CodeFormer.

С портретами в стиле аниме лучше справляется GFPGAN, с реалистичными цифровыми и 3D артами — CodeFormer.

В процессе «исправления лиц» CodeFormer добавляет больше реалистичных деталей и стремится восстановить пропорции, что приводит к искажению анимешных изображений.

Это не значит, что модель не стоит использовать! С её помощью вы сможете улучшить не только черты лица, но и мелкие украшения, причёску, светотеневой рисунок, макияж. Главное — запомните её особенности и будьте готовы прогонять арты несколько раз через алгоритм восстановления, чтобы получить оптимальный результат.

GFPGAN предлагает одну опцию для восстановления лиц, регулирующуюся от 0 до 1. На 0 восстановление не используется, на 1 — включено на максимум.

CodeFormer предлагает 2 опции - первая аналогична GFPGAN, вторая - "Fidelity" ("Достоверность") - влияет на качество и точность воссоздания изображения. Чем ближе второй параметр к 0, тем выше качество, но меньше точность, чем ближе к 1, тем ниже качество, но аккуратней результат.

Рекомендую использовать значения от 0 до 0,6. Передвигая ползунок ближе к 1, вы можете значительно ухудшить качество картинки.

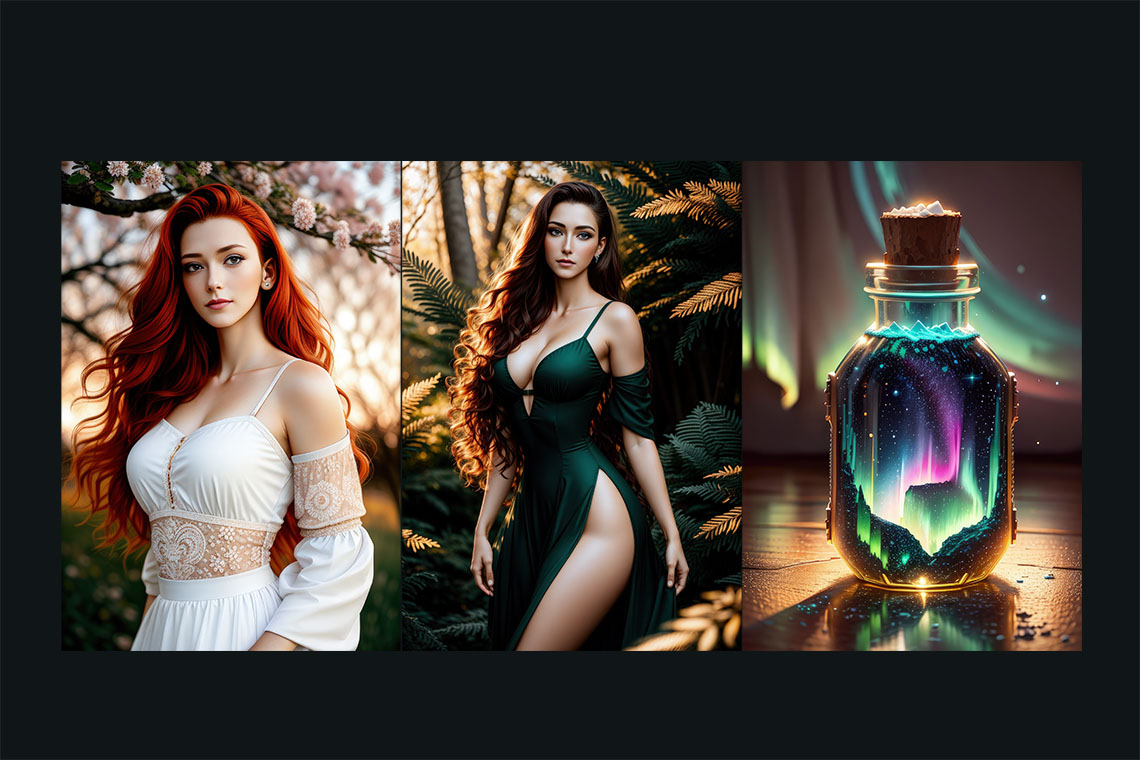

Примеры артов в Stable Diffusion и Waifu Diffusion

В каких случаях лучше не использовать NMKD?

NMKD не стоит использовать, если вы хотите получить больше контроля над процессами объединения моделей, ручной настройкой, стилизацией, использовать альтернативные сэмплеры и алгоритмы, либо после появления новых экспериментальных нейросетей, требующих особенных дополнений, сильных изменений в коде или внедрения форматов, ранее отсутствующих в GUI.

Поскольку приложение редко получает крупные обновления, поддержка новых форматов файлов, сэмплеров и моделей нейросетей добавляется заметно позже конкурентов.

Например, в начале января 2023 года дистрибутив не поддерживал SD 2 и SD 2.1, а также все модели на их основе.

Поэтому рекомендую установить WebUI от Automatic1111, если модель нейросети 100% рабочая, но выдаёт ошибки в NMKD.

Понравилась статья? Поддержите автора комментарием, донатом, подпиской на Telegram и другие страницы!

36 комментариев

Претор

Здравствуйте. Я установил nmkd, а там SD 1.5 в формате diff. A скачиваемый файл wd 1.3 в формате skpt. Nmkd сначала лагает, да весь windows лагает, потом выдаёт что-то типа «у вас лагат возможно из-за того, что модель в формате skpt, возможно вам стоит конвертировать wd в diffusers. А потом вместо генерации начинает качать какой-то python файл размером 1.7 гб. Я отменил и начал конвертировать встроенным в nmkd конвертором в расширение diffuser, он вроде начал конвертировать, но очень долго. Сейчас жду когда закончится. Единственное, заметил, что в диспетчере задач видно, что python.exe что качает. Возможно это как-то связано с конвертацией…

Tengyart

Здравствуйте!

Новая версия преобразует как ckpt, так и safetensors в diffusers. Не знаю, чем обусловлено данное решение, но замедление будет наблюдаться при каждом запуске новой модели. После конвертации картинки генерируются значительно быстрее, чем в старых версиях NMKD или Automatic1111, но при этом приходится долго ждать.

Чтобы избавиться от проблемы, можно установить одну из ранних версий NKMD. Например, 1.9.1. Однако там получится запустить модели только в формате .ckpt!

Если использовать новые версии (начиная от 1.12.0), можно запускать модели всех форматов — ckpt, diff, safetensors, sdxl. Stable Diffusion XL запускает без преобразования, но тоже со значительным затупом на старте. Как от долгой загрузки избавиться, пока не нашёл.

Если использовать SDXL, есть две идеи — включить / выключить Model offloading и установить ПО с моделями на SSD.

Model offloading уменьшает нагрузку на видеокарту, используя ресурсы RAM. Если видеопамяти 8 Гб и меньше, включение SDXL поможет ускорить генерацию изображений. Но если видеопамяти будет значительно больше (16-24 Гб), нет необходимости выгружать часть ресурсов в оперативку (это лишь замедлит генерацию), так что model offloading стоит отключить (включать обратно только в том случае, если скорость генерации значительно уменьшится).

Установив NMKD на SSD и скопировав модели на диск (особенно Stable Diffusion XL!), вы получите небольшое ускорение загрузки и меньший лаг при переключении между моделями. В целом, запускать SDXL можно и на обычных HDD, разница не настолько большая, но всё равно приятная)

Возможно, «нормальная» загрузка для всех форматов появится в следующих версиях… А до тех пор остаётся либо смириться с недочётом, либо использовать Automatic111 или ComfUI.

Михаил

Здравствуйте. Спасибо за полезные и подробные гайды, особенно по установке automatic1111. Когда дойдут руки до установки, обязательно воспользуюсь. А пока пользуюсь nmkd. Он работает, только выдает ошибку no cuda gpus available. С чем это связано и как можно испрвить? Видеокарта GTX1080

Tengyart

Вам спасибо!

Сначала можно попробовать обновить драйвера видеокарты, установить или переустановить Nvidia GeForce Expirience, а затем уже обновляться. Видел на Reddit, что у некоторых пользователей с 10-й серией видеокарты тоже не отображались, а после переустановки появились в меню NMKD.

Но я не могу гарантировать, что этот способ рабочий и не потратит ваше время зря.

Из дополнительных (но не обязательно рабочих!) советов могу рекомендовать:

— Переустановить Python, не забыв поставить галочку Patch в процессе. При необходимости его можно удалить, очистить реестр, а затем уже выполнить переустановку, но это лучше делать только в случае появления постоянных багов и конфликтов с другим ПО;

— Задать вопрос в Discord единомышленникам из сообщества NMKD или попробовать достучаться до разработчика, чтобы узнать напрямую, как можно решить вашу проблему. Лучше всего не писать в личку автору GUI, а вместо этого использовать канал stable-diffusion-gui (так будет выше шанс, что вам ответят, а не заблокируют).

Евгения

Добрый вечер ! Помогите пожалуйста советом!

При запросе возникает ошибка : «your GPU ran out of VRAM! try a lower resolution…»

разрешение 320*320 при этом и видеокарта у меня geforce rtx 3050 8Гб на буке,

Это такой глюк , да ? По системе я подхожу , у меня нитро5 ,Что делать ? Писать разработчику ?)))

Tengyart

Здравствуйте!

Извините, поздно увидел ваш вопрос.

Характеристик видеокарты более чем достаточно для генерации картинок такого разрешения, да и большего тоже. Например, я использую на одной из машин старую видеокарту — RTX 2070 Super, но она тянет как мелкие изображения, так и более 1024 пикселей (только медленно). Единственное, что ещё может вызывать проблемы — нехватка оперативной памяти. Для использования NMKD желательно иметь не меньше 16 или 32 Гб оперативной памяти. Если в системе всего 8 Гб, нужно активировать и настроить Pagefile в ОС (файл подкачки), так как без него программа может вылетать.

Могу предложить три варианта действий:

1) Как вы и сказали, написать разработчику. Возможно, это реально баг;

2) Переключиться в настройках NMKD (в разделе Image Generation Implementation) на Stable Diffusion (OptimizedSD — CUDA — Low Memory Mode). Опция Low Memory Mode несколько замедлит генерацию, но она предназначена для систем с 4 Гб видеопамяти, поэтому может помочь решить проблему с VRAM;

3) Использовать другой софт. Например, Automatic1111 или InvokeAI. Automatic1111 обновляется намного чаще, чем NMKD, является самым массовым решением на рынке, поэтому есть немалая вероятность, что там будет меньше багов. А ещё у него намного больше настроек и возможностей! Только вам понадобится большевремени, чтобы его установить и досконально изучить)

P.S. Надеюсь, эти советы вам помогут или решить проблему, или найти другой софт, который больше подходит для генерации изображений.

Алексей

Добрый день!

Не получается конвертировать модели, все время выдает ошибку failed to convert model. Единственный рабочий вариант из ckpt в diffusers. Может есть иной способ или типовая проблема? Или как вариант место где раздают все «типы» моделей, я лично не находил.

Tengyart

Добрый день!

Возможно, причиной ошибки стало то, что NMKD не поддерживает исходную модель. Например, пока не добавлена поддержка SD 2+, поэтому с такими моделями могут возникнуть проблемы.

Могу предложить попробовать альтернативные конвертеры. Например, Ckpt2Safetensors Conversion Tool (GUI можно установить на Windows, не требует установки NMKD или Automatic1111), либо скачать sd-webui-model-converter — дополнительный модуль для Automatic1111 (отдельно без Aitomatic1111 не работает).

Ещё можно изучить гайд на Rentry, там прописано больше информации о конвертации. Я им не пользовался, но, возможно, там будут какие-либо полезные сведения, которые вам помогут.

Различные типы моделей часто выкладывают на Civitai. Однако учитывайте, что там встречается много моделей 18+, поэтому сайт не подходит для просмотра на работе)

Когда вы откроете страницу с нужной моделью (например, вбив название в поиске или изучив список на главной странице), посмотрите на синюю кнопку с надписью Download. Если в правом углу есть возможность выбрать модели (при наведении на стрелочку вылезает надпись Other Downloads), значит, было залито несколько типов моделей. При нажатии на чекбокс со стрелочкой вниз появится список доступных моделей или VAE. Чтобы сказать версию в ckpt, скачивайте Model PickleTensor.

Жаль только, что подходящие модели заливают не так уж часто, поэтому Civitai не всегда может быть подходящей альтернативой ручному конвертированию моделей нейросетей.

Аноним

Здравствуйте. Большое спасибо за гайд, добрый человек !

Поддерживает-ли NMKD формат моделей Safe Tensor ? И если да, то куда их запихивать ?

Tengyart

Здравствуйте!

NMKD версии 1.8.1 не поддерживает safetensors, поэтому вам понадобится конвертировать модель в другой формат. Например, ckpt.

Чтобы конвертировать модель, сначала скопируйте её в папку models, затем запустите NMKD, нажмите на иконку с изображением гаечного ключа, кликните на пункт Convert Models, после чего укажите в разделе Model Input Formats формат Safetensors (safetensors file), в Model File — модель, которую хотите конвертировать, в Model Output Format — новый формат модели. В версии 1.8.1 конвертирует только в Pytorch (ckpt/pt), но это как раз то, что требуется для NMKD.

Для запуска конвертации останется нажать кнопку Convert и немного подождать.

Как только конвертация модели нейросети закончится, она сохранится с тем же названием, но с расширением .ckpt, после чего её можно будет выбрать в настройках NMKD и использовать для генерации изображений. Если вам не нужен исходник, перед конвертацией модели можно выделить чекбокс напротив надписи Delete Input File If Successful (в таком случае после успешной конвертации удалится файл с расширением .safetensors).

Однако учитывайте, что конвертировать модели на базе SD 2.0 или SD 2.1 в NMKD бесполезно, поскольку GUI не поддерживает подобные модели нейросетей. Когда точно добавят поддержку — неизвестно, поэтому для комфортной работы лучше использовать другие GUI. Например, Automatic1111.

Pavel

Ставлю waifu-diffusion-v1-4, пишет Canceled: Process has errored: Failed to load model. The model appears to be incompatible.

Tengyart

Проблема возникает из-за особенностей NMKD — в GUI всё ещё не добавили поддержку SD 2.1, поэтому все модели на базе Stable Diffusion 2.1 в программе не запустятся.

Пока не добавят поддержку, Waifu Diffusion 1.4 лучше использовать в Automatic1111, в котором можно запустить как старые, так и новые виды моделей.

Максим

Здравствуйте, установил все по инструкции, но не отображается модель в настройках. У меня видеокарта от AMD. Заметил, что модель не отображается в режиме для AMD, а в режиме CUDA все ок. Что может быть?

Tengyart

Здравствуйте!

Скорее всего, скачанные вами модели не подходят для видеокарт AMD, поэтому вам нужно их конвертировать, либо скачать подходящие в сети (я не пользовался AMD, поэтому с последним помочь не смогу).

Чтобы конвертировать модели, нажмите кнопку с гаечным ключом в главном окне NMKD и выберите Convert Models. Укажите файл модели, который требуется преобразовать (например, sd-v1-5-fp16.ckpt), затем новый формат — Diffusers ONNX (Folder), потом нажмите кнопку Convert и дождитесь завершения процесса.

Когда модель конвертируется, зайдите в настройки (F12), переключитесь в разделе Image Generation Implementation на Stable Diffusion (ONNX — DirectML — For AMD GPUs) и выберите преобразованную модель из списка. Если настройки по умолчанию уже совпадают с тем, что я написал, выбрать модель можно будет с помощью быстрого переключения (Ctrl+M).

Дальше процесс ничем не отличается от стандартного — достаточно ввести текстовую подсказку, подогнать под себя настройки и нажать кнопку Generate!

Учитывайте, что NMKD при переключении на AMD не поддерживает часть функций, например, генерацию плиточных изображений или поддержку пользовательских сэмплеров.

Гугл выдаёт ещё некоторые особенности, которые необходимы для работы с AMD:

— Для использования ПО и нейросетей понадобится видеокарта, поддерживающая DirectML (например, AMD 6XXX серии);

— Как минимум один файл модели Pytorch (ckpt) (включен в обычную загрузку SD GUI объемом 3 ГБ).

Не знаю, насколько критичен последний пункт. Если после конвертации модели всё запускается, можно не скачивать версию на 3 ГБ, если нет, то лучше перестраховаться и повторить всю последовательность действий после распаковывания GUI.

Надеюсь, эти советы вам помогут!

Роман

Здравствуйте. Спасибо большое за гайды! Скажите, пожалуйста, если я скачал с сайта itch.io версию GUI 1.8.0 (такая стоит по вашей ссылке на сайт), то там уже будет цензура, или она только начиная с версии 2.0?

Tengyart

Здравствуйте! Наличие или отсутствие цензуры зависит от модели, которую вы будете использовать вместе с NMKD, а не от версии GUI. Само приложение никак не ограничивает ваши действия)

Лучше всего смотреть на превью картинок в описании нейросети или примеры работ других пользователей, чтобы понять, будет в результате цензура или нет. Но даже если будет или появится только во время использования, это не страшно — достаточно скачать другую модель нейросети, залить в папку Data -> models, выбрать её в настройках, затем генерировать арты без цензуры и каких-либо запретов!

P.S. Версию 2.0 или миксы с ней лучше пока не использовать — NMKD версии 1.8.0 их всё ещё не поддерживает. Скорее всего, в новых версиях это исправят, но для вариантов SD2+ лучше установить AUTOMATIC1111 или другие дистрибутивы, поддерживающие новые варианты нейронных сетей.

P.P.S. Большое спасибо за комментарий!

Диана

Есть ли какая-то специальная настройка, чтобы демонстрировался ролцесс генерации картинки?

NMKD Stable Diffusion GUI — какая настройкеа влияет? Картики конечные показывает, а процесс генерации нет.

Tengyart

Насколько помню, в NMKD такой опции нет. Если для вас это критично, попробуйте использовать другой дистрибутив.

Andrey

Здравствуйте, когда я уже всё установил и начал свою генерацию, у меня выскакивает ошибка

Your model file seem to be damaged or incomplete!

RuntimeError: PytorchStreamReader failer reading zip archive: failed finding central directory

Всё переустанавливал и ничего

Tengyart

Судя по описанию ошибки, скачанная модель повреждена или сохранена частично.

В таком случае будет достаточно скачать её заново или попробовать использовать другие модели. Если они вызовут тот же баг, значит, проблема не в моделях, а в коде NMKD. Например, не установилась часть файлов после нажатия Re-install.

Во втором случае будет достаточно заново запустить Installer, затем Re-install SD Code или Re-Install, чтобы переустановить все компоненты.

Есть ещё один вариант, почему может возникать ошибка.Если вы используете SD 2.0 или пользовательские нейросети, базирующиеся на Stable Diffusion 2, NMKD может их не воспринимать (пока полноценную поддержку для SD 2.0 не добавили, поэтому подобные модели могут не запускаться).

В таком случае лучше использовать другой дистрибутив — Automatic1111. У него больше возможностей, чем у NMKD, но не такой удобный интерфейс + вам понадобится сделать больше действий для установки и запуска дистрибутива. На странице разработчика есть инструкция с подробностями на английском языке.

Если ничто из этого не помогло, возможно, дело в одном из файлов в папке C:\Users\%USERNAME%\.cache\torch\hub\checkpoints

Удаление файлов из кэша с последующей переустановкой софта может помочь, но есть шанс возникновения новых проблем.

P.S. У меня нет достаточных знаний, но я надеюсь, что хоть один из этих советов поможет вам и вашим экспериментам!

Андрей

Здравствуйте, при установке в самом gui пишет такую ошибку:

Failed to install python environment: Can’t delete existing folder.

Можно как-то пофиксить?

Tengyart

Здравствуйте!

Не сталкивался с таким сбоем, поэтому могу дать только непроверенные советы.По описанию ошибки можно предположить, что GUI не устанавливается из-за того, что не может переписать файлы в установленной ранее папке с Python. Достаточно будет её удалить, запустить установку, либо установить перед запуском NMKD свежую версию Python с официального сайта. Версия 3.10 стабильно работает с NMKD, можно начать с неё.

Чтобы удалить Python, сделайте следующие действия:

1) Перейдите в C:\Users\%USERNAME%\AppData\Local\Programs

2) Удалите папку Python

3) Перейдите в панель управления, оттуда в раздел «Удаление программ»

4) Щёлкните правой кнопкой мыши на Python, затем нажмите «Удалить» во всплывающем окне

5) Установите Python

Вместо «Панели управления» на Windows 10 можно перейти в «Пуск», «Параметры», «Приложения и возможности», «Программы и компоненты». Удалить Python можно и там)

Дополнительно перед установкой Python можно очистить кэш и реестр, чтобы уменьшить вероятность новых ошибок.

Хотя можно не усложнять себе жизнь и деинсталлировать Pytnon, выполнив только шаги 3 и 4. Установить подходящую версию должен и NMKD, к тому же, в настройках GUI есть возможность переустановки окружения. Чтобы переустановить Python и все компоненты, достаточно нажать на иконку с монитором и стрелочкой вниз в правом верхнем углу NKMD, затем щёлкнуть Re-install.

P.S. Пока думал, что посоветовать, нашёл ещё инструкцию на Stackoverflow, но она заточена под linux.

Павел

Здравствуйте, так-с значит с деформацией тел я разобрался, есть вопрос.. например я получил желаемую картинку.. хочу на основании ей сделать другие вариации… как такое сделать?

Tengyart

Здравствуйте, Павел!

Есть два способа сделать вариации на основе созданной картинки:

1) Скопировать цифровое значение из поля Seed (находится в метаданных или названии картинки, выглядит примерно так — 1708835393), изменить текстовую подсказку и запустить генерацию. Чем сильнее вы измените запрос, тем больше разницы будет между исходником и новыми картинками;

2) Использовать арт в качестве референса — загрузить созданное изображение с помощью кнопки «Load Image», настроить запрос и запустить новую генерацию. Этот вариант даёт больше вариативности за счёт дополнительных настроек, рекомендую использовать его.

Далее подробнее расскажу про второй способ.

После добавления картинки появится параметр Initialization Image strength (influence) — степень влияния изначального изображения. Чем ближе к 1, тем сильнее новые картинки будут похожи на оригинал, чем ближе к 0, тем больше новых деталей добавится, а сходства станет меньше. На мой взгляд, оптимально ставить значения Influence от 0,25 до 0,7. Ниже будет слишком много рандома, выше — недостаточно вариативности.

Помимо IIS, после добавления картинки появится опция Masking Inpainting («Маскировка и закрашивание»). Если активировать её (выбрать «Draw mask» в выпадающем меню), перед генерацией новых картинок появится возможность выделить области, которые вы хотите изменить.

Masking Inpainting стоит использовать, если вам нравится исходник, но хочется заменить какие-то определённые детали - например, руки или лицо, либо какой-то элемент одежды. А ещё это удобно - можно сильно модифицировать запрос, не угробив при этом всю картинку)Стоит отметить, что при создании новых артов на основе картинок есть 2 минуса.

Во-первых, появляется больше искажений.

Если вы генерируете персонажей, стоит использовать «Восстановление лиц» в дополнительных настройках NMKD или Automatic1111, иначе на картинку будет сложно смотреть без боли. Или же потом понадобится переносить лица с удачных изображений в графическом редакторе, что уже не так уж и удобно.

Во-вторых, после маскирования может падать резкость всех областей, кроме замаскированных частей картинки.

Это тоже не проблема, но их уже наверняка придётся совмещать, чтобы избавиться от замыленности.

Надеюсь, мой ответ вам хоть немного пригодится!

Павел

Картинка получается обрезанная, точнее тело есть а лицо где то вверху.. как центрировать что бы был портрет например или человек во весь рост?

Tengyart

Чтобы в нейросети не обрезались головы, попробуйте использовать «негативные подсказки» (negative prompt). Например, вот такими:

lowres, ugly, bad anatomy, deformed body, missing fingers, extra fingers, blurry, deformed face, cropped, cropped face, text, conjoined twins, siamese twins, weapon, sword, gun, chibi, weird eyes, worst quality, low quality, jpeg artifacts, username, artist name, blind, unibrowНегативные подсказки помогают исключать то, что вы бы не хотели видеть в сгенерированной картинке. Уменьшить вероятность обрезки лиц и тел поможет cropped, cropped face, понизить шанс удвоения тел и рук — bad anatomy, deformed body, missing fingers, extra fingers, deformed face, conjoined twins, siamese twins.

Учитывайте, что чем больше ограничений вы пропишите, тем хуже будет качество картинки. Во-первых, уменьшится вариативность, во-вторых, нейросети могут начать смешивать обычные и негативные подсказки, выдавая чудовищный результат. Поэтому лучше одновременно использовать лишь часть слов, а не всё сразу. Разумеется, вы и сами можете прописать ограничения, я лишь привёл некоторые рабочие варианты.

Помимо «Негативных подсказок», можно дополнять запрос словами, акцентирующими внимание на лице:

Face, beautiful face, portrait, close-up, headshot, looking into camera, makeup, look at viewer

Если в установленной версии NMKD нет негативных подсказок, пожалуйста, перейдите на страницу проекта и скачайте свежую версию. Удобный способ добавления «отрицательных слов» работает с версии 1.7.0, либо в большей части версий AUTOMATIC1111.

Надеюсь, эти советы вам помогут!

Анатолий

ДА тут же пароль на Вин Раре и как узнать какой?

Tengyart

Только что всё заново скачал, архив открывается без проблем, при установке софта не требуется ни пароль, ни что-либо ещё.

Возможно, у вас нелицензионный WinRar?

В таком случае рекомендую использовать другое ПО для распаковки архива. Тем более, .7z считывается практически чем угодно.

Shido15

Здравствуйте, как в этой нейросети отключить цензуру ?

Tengyart

Я вам уже достаточно подробно в WhatsApp написал, но отвечу и для других подписчиков сайта — Stable Diffusion, Waifu Diffusion, слитый Novel AI и Anything v3.0 не включают никаких цензурных фильтров. Поэтому для генерации артов в белье или ню не требуется ничего особенного, кроме тщательного подбора текстовых подсказок и негативных слов (всего, чего вы хотите избежать на создаваемых картинках).

Учитывайте, что «отсутствие цензуры» будет исключительно в нейросети, работающей на вашем ПК, но не на сайте в браузере!

Самые популярные браузерные версии могут ограничивать выдачу, прерывать создание картинок или добавлять «цензуру», поэтому их лучше использовать для создания «безопасного контента».

Shido15

Здравствуйте, как цензуру в Stable Diffusion ?

Dmitry

Спасибо, всё запустилось, работает. Но чаще получаются какие-то кривые и депрессивно-ужасные картинки. Как вы делаете такие как в посте? Записали бы хоть видио по программе, рассказали, было бы интересно посмотреть.

Спасибо за материал!

Tengyart

Вам большое спасибо за комментарий!

Чтобы получить результат получше, стоит уточнить запрос: добавить больше деталей в текстовое описание, «позаимствовать» стили художников, указать свойства и условия (например, «высокая детализация, кинематографическое освещение, 2D арт, тренды Artstation»), попробовать изменить количество деталей и «креативности» нейросети.

Помимо этого, можно подсмотреть варианты текста на входе у других пользователей. Самый простой способ это сделать — воспользоваться сайтом Lexica, ключевыми словами для Midjourney, либо изучить раздел Stable Diffusion на Reddit.

Чтобы получить больше красивых лиц, вместо SD лучше использовать Waifu Diffusion 1.2 — 1.3, либо одну из бета-версий WD 1.3. Поскольку время обучения и количество изображений для тренировки отличаются, результаты тоже будут варьироваться.

В новой версии NMKD появилась дополнительная опция восстановления лиц, использующая CodeFormer. С её помощью вы будете реже получать «кривые» портреты, но, на мой взгляд, результаты генерации станут несколько однообразными.

Я не очень силён в видео, но надеюсь, что вам пригодятся ссылки и мой ответ)

MORKAUD

Доброго дня.

Спасибо большое за подробный материал, уж месяц как планировал углубиться в матчасть и начать развертывание, а тут оказывается, к нашим дням и GUI прикрутили

Никита

Спасибо, долго разбирался с SD и думал неужели нельзя обойтись без всех этих пайтонов, гитов и т.д.? Просто раньше я никогда не занимался подобным. И вот классная статья с самым легким способом. Еще и сразу про waifu diffusion написано!

Tengyart

Большое спасибо за приятный комментарий!

Раз вам статья пригодилась, значит, не зря написал инструкцию)