Cerebrum 7b GGUF: обзор модели и возможности LLM

Что такое Cerebrum 7b?

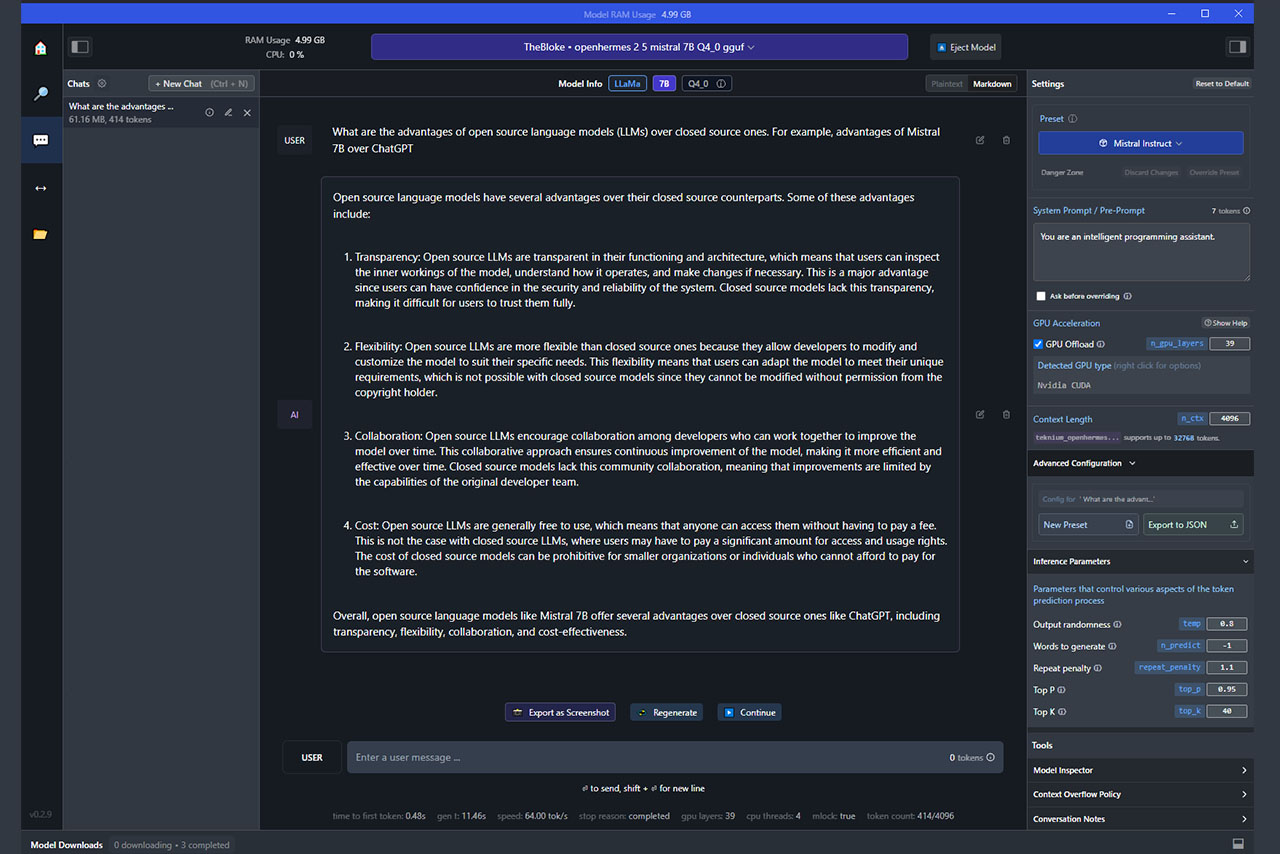

Cerebrum 7b — большая языковая модель (LLM), опубликованная AetherResearch в 2024 году. Создана для решения задач, требующих навыков рассуждения и творческого подхода. На запросы пользователей отвечает ёмко и коротко. Однако при повышении «креативности» (Output randomness, Top K) нейросеть чаще искажает вводные данные и добавляет в текст несуществующие подробности, чем большинство других моделей на базе Mistral 7b.

LLM обучена на 5000 обучающих подсказок, чтобы генерировать точные ответы и действовать более "логично". Для достижения этих целей разработчики использовали tRLHF - целевое обучение с подкреплением на основе обратной связи с людьми (с пользовательской оценкой результатов генерации).

Информация от разработчиков

- Модель нейросети будет полезна для прикладных задач: получения коротких ответов, математических вычислений, исследований, программирования, поиска ошибок;

- Обгоняет Mistral 7b и Llama 2 70b в синтетических тестах, требующих навыков рассуждения, включая ARC Challenge, GSM8k и HumanEval;

- Для получения наилучшего результата в системной подсказке стоит указать, что ИИ-ассистент подробно описывает свой мыслительный процесс и даёт полезные ответы на запросы пользователя.

Пример системной подсказки на английском (её можно модифицировать под себя!):

<s>A chat between a user and a thinking artificial intelligence assistant. The assistant describes its thought process and gives helpful and detailed answers to the user's questions. User: Are you conscious? AI:

Плюсы Cerebrum 7b

- Модель в 60% случаев избегает длинных ответов, генерируя максимально короткий текст (удобно для получения полезной информации и новых идей);

- Подходит для образовательных публикаций, наукоёмких задач, творческих заметок;

- Редко повторяется и зацикливается, в том числе на низких температурах (0.1-0.4);

- Максимальная длина контента — 32 000 токенов;

- Воспринимает запросы на русском языке, хоть и не всегда 100% точно.

Минусы Cerebrum 7b

- Модель склонна к искажению данных, особенно после изменения настроек в сторону большей креативности;

- Плохо справляется с коротким пересказом текста;

- Не подходит для генерации новостных статей, новелл и романов;

- Посредственные результаты при генерации NSFW-контента (не подходит для RP и ERP);

- Не поддерживает формат ChatML. Хотя информация из системной подсказки учитывается, адекватно воспринимает только формат Alpaca;

- Отвратительное качество текста на русском языке. Проще просить модель написать ответ на английском, а потом уже перевести его на русский через DeepL (например, если вам сложно адаптировать текст самостоятельно), чем пытаться «причесать» криво сформированные ответы, полученные в LLM. Впрочем, это касается большинства существующих языковых моделей с семью миллиардами параметров.

Кому подойдёт эта модель?

- Энтузиастам, тестирующим новые LLM;

- Авторам, генерирующим посты для блогов, в том числе для X и Telegram;

- Творцам, нуждающимся в новых идеях и коротких ответах на вопросы;

- Экспериментаторам, желающим облегчить «мозговой штурм» при решении сложных проблем;

- Людям, которым хочется проверить очередного чат-бота, выполняющего точные инструкции.

Рекомендую самостоятельно изучить возможности модели, а уже после думать, стоит ли её использовать в повседневной деятельности.

Где скачать Cerebrum 7b?

- В формате .safetensors — на странице разработчика;

- В формате GGUF (Q2_k-Q8_0) — в коллекции Bartowski на HuggingFace;

- В формате exl12 — в ещё одной коллекции на HF.

Удачных экспериментов!

Понравилась статья? Поддержите автора репостом, комментарием, подпиской на Telegram и другие страницы!