Какой метод квантования LLM популярней в 2024 году?

Чтобы рассчитать востребованность различных методов квантования больших языковых моделей, я использовал три источника данных:

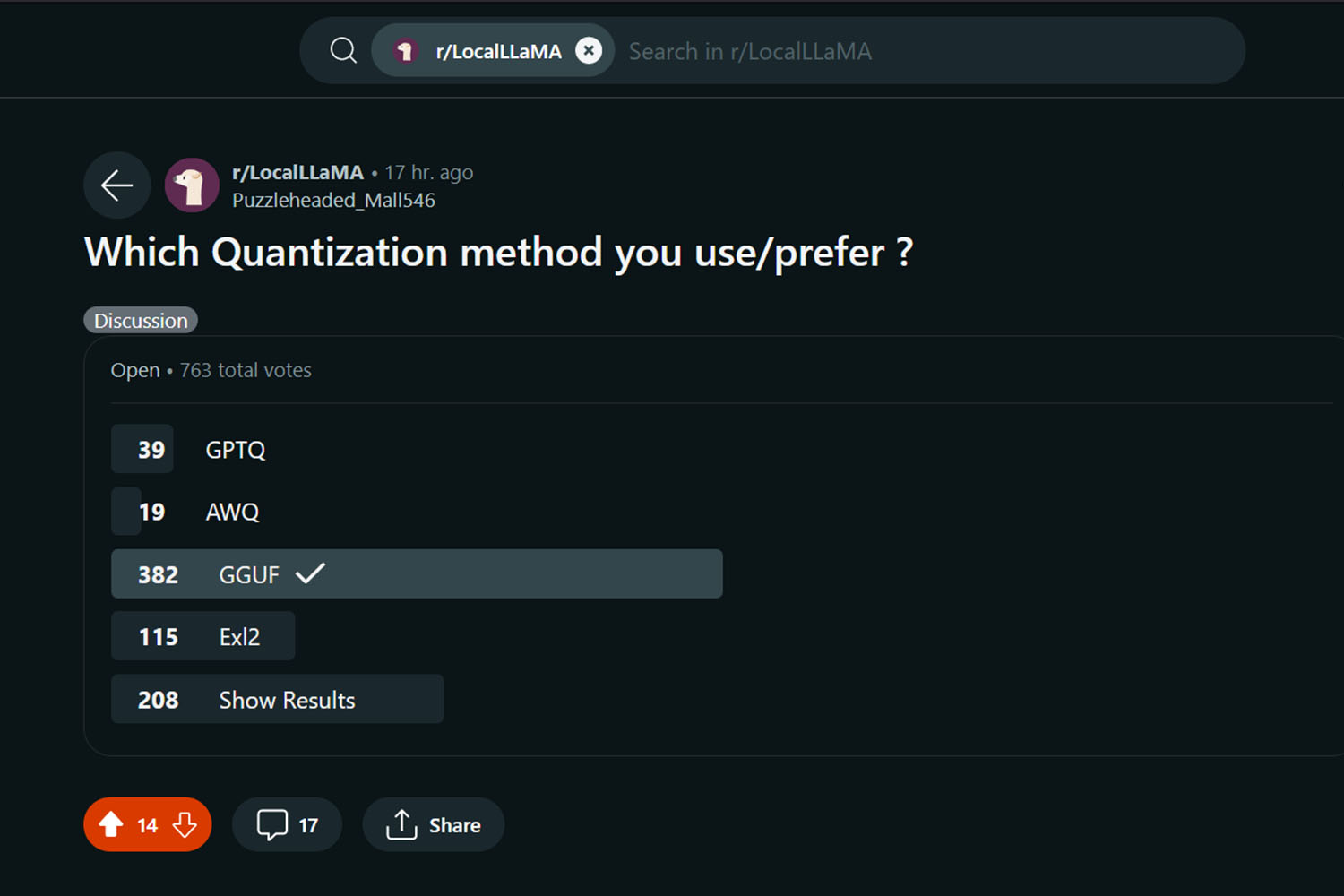

- Голосование за самый популярный метод квантования LLM на Reddit. На момент написания статьи в опросе приняло участие свыше 760+ человек, активно применяющих нейросети для работы и творчества. Хотя это не самая большая выборка, она отлично отображает реальную востребованность квантованных моделей среди пользователей;

- Комментарии и посты на Reddit в разделе r/LocalLLaMA. Например, с просьбами выложить тот или иной квант, либо содержащих подходящие версии моделей. Учитывал только популярные записи за февраль-март 2024 года;

- Общее количество публикаций на HuggingFace. С их помощью можно отследить изменения в динамике релизов и оценить, какие варианты квантования стагнируют, а какие — стремительно набирают популярность.

А теперь перейдём к цифрам.

В опросе на Reddit приняло участие 763 пользователя, 208 из которых предпочли посмотреть на результаты голосования. Чтобы подсчёт был чистым, я не учитывал их в общей статистике. В итоге за разные методы квантования проголосовали 555 человек. Из них 382 (68,82%) выбрали GGUF, 115 (20,72%) - exl2, 39 (7,027%) - GPTQ, 19 (3,423%) - AWQ.

В постах на LocalLLaMA пользователи чаще всего спрашивают про GGUF и exl2, причём (даже на первый взгляд!) постов с GGUF в 3-4 раза больше. Это вполне коррелирует с результатами опроса, приведённого на странице выше.

AWQ и GPTQ суммарно упоминаются в 13% случаев, GGUF и exl2 — в 87%.

По отдельности: AWQ - 6,1%, GPTQ - 6,9%, exl2 - 17,3%, GGUF - 69,7%. Перечисленные методы квантования LLM (точнее, их соотношение) слабо отражают их реальную популярность, потому что в постах часто прикрепляют модели в разных форматах. Кроме того, как посты, так и комментарии могут изменяться авторами или удаляться модераторами, из-за чего получилось зафиксировать лишь приблизительные процентные значения.

Если учитывать только просьбы о добавлении нужных квантов, безоговорочным лидером будет GGUF, который упоминали в 83% случаев!

На HuggingFace опубликовано свыше 6106 моделей с пометкой GGUF, 4049 — exl2, 2516 — GPTQ, 1761 — AWQ. Учитывая общее количество LLM, GGUF-версия есть у 42,308% существующих текстовых нейросетей, exl2 — 28,055%, GPTQ — 17,433%, AWQ — 12,203% моделей.

Здесь разрыв между GGUF, exl2 и остальными популярными методами квантования уже не так заметен. Но это можно легко объяснить!

Во-первых, до февраля 2024 года на HF был разработчик, активно конвертирующий модели в GGUF, GPTQ и AWQ — TheBloke. Он публиковал квантованные версии практически для всех новинок, поэтому многие авторы стали полностью полагаться на него. Когда TheBloke занялся другими проектами, в его коллекции хранилось 3863 языковых модели (это 26,76% от общего количества квантов, опубликованных на HF)!

Получается такая картина: популярный "мастер квантования" ушёл, а его место не спешили занимать как авторы моделей, так и другие энтузиасты, которым не хотелось конкурировать с TheBloke. Активный ренессанс с массовой заливкой моделей начался лишь в марте 2024 года, да и то преимущественно с RP-моделями (LLM для генерации историй и ролевых игр) в диапазоне от 7b до 20b.

Во-вторых, exl2 появился не так давно и (в теории) обеспечивает большую производительность по сравнению с GGUF, поэтому появилось много желающих квантовать модели в этот формат. Иногда это приводило к казусам, например, к появлению небольшого процента «багнутых» LLM, начинающих нести околесицу при повышении «креативности» модели в настройках ПО.

Несмотря на все перспективы, у exl2 нет масштабной поддержки, поэтому рано говорить, что новый формат вытеснит gguf с первого места.

Пока GGUF запускается практически где угодно, удобен и прост в использовании, exl2 будет сложнее завоевать сердца энтузиастов.

Так какой же метод квантования LLM популярнее всего?

Если сложить все результаты (опрос на Reddit, упоминание квантов, распределение моделей по частоте заливки), а затем привести их к средним значениям, самый популярный метод квантования LLM — GGUF (60,276%), за ним идёт exl2 (22,025%), GPTQ (10,453%) и AWQ (7,242%).

Стоит учитывать, что в будущем процентное соотношение может измениться!

Могут появиться новые варианты квантования, которые будут удобней всего, о чём я рассказывал. Либо опрос выстрелит в сети, привлекая внимание тех, кто запускал нейронки только в одной среде и не знает, как ведут себя другие форматы. Или же вернётся TheBloke и резко увеличит количество GPTQ и AWQ, поломав статистику "востребованных квантов".

Так что считайте проценты лишь примерными значениями «популярности» и пользуйтесь тем, что вам удобнее запускать!

Удачных экспериментов~

Понравилась статья? Поддержите автора репостом, комментарием, подпиской на Telegram и другие страницы!